Revolusi NLP dengan Swin Transformer

Di tengah perkembangan Natural Language Processing (NLP), para peneliti terus berusaha untuk meningkatkan kinerja model dan efisiensinya. Di antara terobosan terbaru, Swin Transformer merupakan salah satu yang menonjol dalam perkembangannya. Pendekatan baru terhadap transformer ini berguna untuk merevolusi cara kita memahami dan memproses bahasa.

Sebelum memahami Swin Transformer, kita perlu memahami transformer terlebih dahulu. Transformer adalah jenis model Deep Learning dalam bidang NLP. Kemampuannya dalam menangkap informasi kontekstual, memodelkan long-range dependencies, dan menampilkan performa yang sangat baik dalam berbagai tugas pemahaman bahasa telah menjadikannya landasan penting pada bidang ini. Namun, transformer tradisional seperti BERT, GPT, dan lainnya seringkali memerlukan sumber daya komputasi dan memori yang besar, membuatnya sulit diimplementasikan dengan efisien. Solusi dari permasalahan tersebut dapat diatasi oleh Swin Transformer.

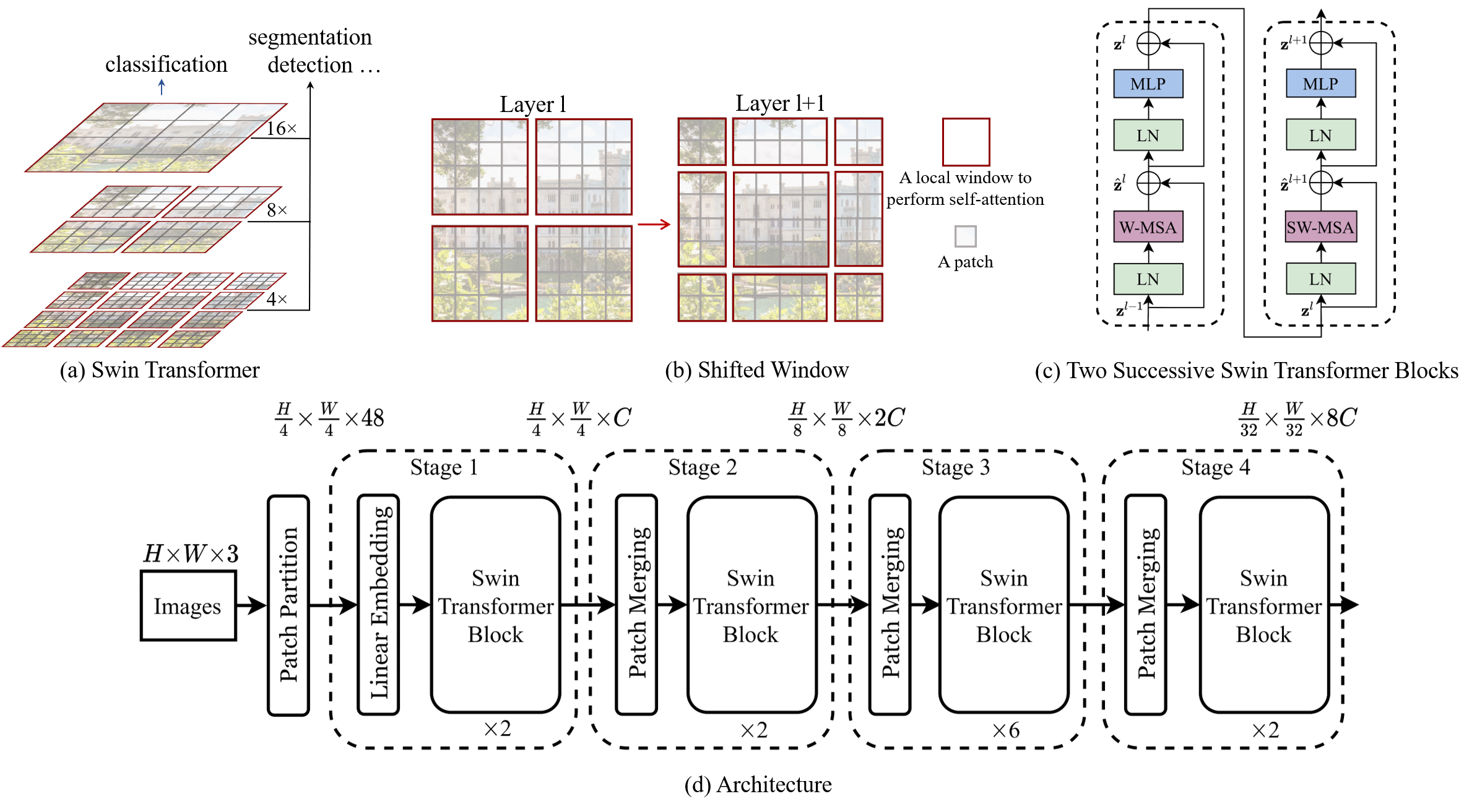

Swin Transformer, singkatan dari “Shifted Window Transformer,” diperkenalkan dalam makalah penelitian tahun 2021 oleh peneliti dari Microsoft Research Asia. Yang membedakan Swin Transformer dari pendahulunya adalah arsitektur inovatifnya yang mengoptimalkan efisiensi komputasi sambil tetap mempertahankan performa terbaik.

Ide inti di balik Swin Transformer adalah membagi input sequence menjadi non-overlapping windows, yang memungkinkannya untuk menyusun sequence dengan efisien yang baik pada jendela tersebut. Alih-alih memproses seluruh sequence sekaligus, Swin Transformer memproses kumpulan window tersebut secara hierarki. Pendekatan ini secara signifikan mengurangi kebutuhan memori dan komputasi, sehingga bisa untuk menangani data teks yang luas.

Fitur Utama dan Keunggulan Swin Transformer

- Pemrosesan Window-Based yang efisien: Pendekatan berbasis Window milik Swin Transformer memungkinkannya untuk menangani sequence dengan panjang yang beragam tanpa mengorbankan performa. Hal ini membuatnya cocok untuk berbagai tugas NLP.

- Pemrosesan Hierarki: Swin Transformer menggunakan strategi pemrosesan hierarki yang secara bertahap memperbaiki representasi input token. Arsitektur ini membantu dalam menangkap informasi kontekstual, baik yang bersifat lokal maupun global secara efektif.

- Komputasi Paralel: Swin Transformer dapat memproses beberapa window secara paralel, sehingga meningkatkan efisiensi dan mengurangi waktu pelatihan.

- Performa yang Terbaik: Meskipun meningkatkan efisiensinya, Swin Transformer mempertahankan performa yang kompetitif dengan model transformer lainnya dalam berbagai benchmark NLP, termasuk klasifikasi teks, pemodelan bahasa, dan lainnya.

Aplikasi dan Implikasi

Swin Transformer memiliki potensi untuk mempengaruhi berbagai aplikasi NLP. Efisiensinya dalam pemrosesan long sequence membuatnya cocok untuk tugas-tugas seperti ringkasan dokumen, jawaban dari pertanyaan, dan text generating. Para researcher dan engineer juga dapat menjelajahi penggunaannya dalam aplikasi multibahasa dan multimodal, memperluas fleksibilitasnya.

Selain itu, efisiensinya dalam komputasi menjadikan Swin Transformer lebih mudah diakses oleh berbagai kalangan, menurunkan hambatan untuk individu dan organisasi yang ingin menggunakan kekuatan transformer dalam proyek-proyek mereka.